Tres estudiantes de la ingeniería de sistemas y computación de la Universidad del Norte desarrollaron una aplicación móvil que traduce lenguaje de señas.

El objetivo de la aplicación móvil es aportar a la inclusión de las personas con discapacidad auditiva y del habla en cualquier ámbito.

Son ellos Carla Durán, Mauricio Maldonado y Juan Carlos Arteaga, estudiantes próximos a egresar del programa de Ing. De Sistemas y Computación.

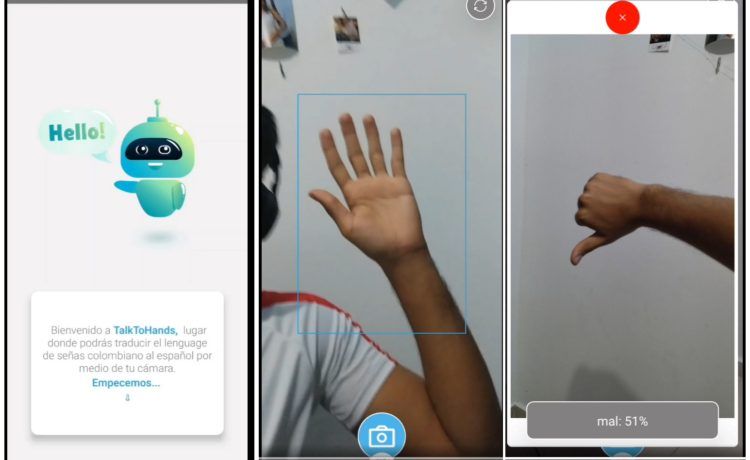

La aplicación Talk to Hands (Hablar con las manos) permite la traducción en tiempo real del lenguaje de señas mediante Inteligencia Artificial (IA).

La idea de crear algún servicio o aplicativo que pudiera aportar a la inclusión y a la sociedad rondaba la mente de este grupo de compañeros.

Desde primer semestre

Desde que estaban en primer semestre tenían este propósito, pero fue en el último que decidieron lanzarse a crear.

Carla Durán explico que “siempre dijimos que queríamos dejar nuestro granito de arena en la sociedad”.

“Las cosas se nos empezaron a dar ya en nuestro último semestre, en la materia de Proyecto de Grado”, anotó.

Para hacer la aplicación se inspiraron en dos situaciones:

La primera es buscar una sociedad más inclusiva y abierta, en la que todos tengamos cabida.

“La segunda fuente de inspiración fue mi tía, quién presenta esta condición y pues tomando su ejemplo de vida nos aventuramos en esto”, explica Carla.

Para ellos, crear este aplicativo presentó un gran reto, ya que les tocó aprender de cero el lenguaje de señas colombiano, el cual no es universal.

Mauricio explicó que hicieron la investigación para aprender que el lenguaje de señas no es el mismo en todos lados, es decir, este se adapta al contexto y lugar en el que se va a utilizar.

“En ese sentido, nosotros aprendimos parte del lenguaje de señas colombiano y desarrollamos este aplicativo teniendo en cuenta eso”, puntualizó.

Data Set de imágenes

Luego de conocer el lenguaje de señas, procedieron a crear un Data Set de imágenes (un banco de imágenes digital) con las palabras y señas del lenguaje de señas.

Así entrenaron la IA para que pudiera reconocerlas y realizar la traducción adecuada.

“En esta parte del proyecto, utilizamos una librería que tiene el lenguaje de programación Python que se llama TensorFlow, el cual es especializado para detección de objetos”, explica.

Agregó que, en este caso, lo usaron para que detectara las palabras y señas del Data Set. Así es como dentro de la app, la IA puede traducir las señas.

Actualmente, el aplicativo se encuentra en la fase prototipo, el cual es 100% funcional.

Ya la aplicación funciona totalmente y cuenta ahora mismo con un porcentaje de acierto de alrededor del 70%.

“La idea es que la aplicación cuente con el apoyo de organizaciones e instituciones especializadas en lenguaje de señas, para que así podamos nutrir el Data Set y aumente el porcentaje de acierto en un 100%”, enfatiza Juan Carlos.

Versión final

Carla Durán agrega que la idea es que “tengamos pronto lista la versión final para que todos los que deseen, puedan acceder desde sus dispositivos móviles a Talk To Hands”.

“Nuestra app será completamente gratuita y, además, hemos compartido nuestro código en GitHub (Plataforma que permite a los ingenieros y programadores compartir códigos fuente, aplicativos y demás recursos informáticos)”, indicó.

Así, quién lo desee, pueda programar su versión de nuestra aplicación y adaptarla a su idioma”.

El grupo de estudiantes destacó el apoyo constante que recibieron durante el proceso de formulación y desarrollo del proyecto.